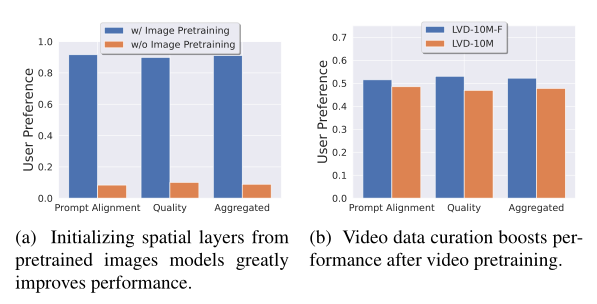

扩散模型视频生成:Stable Video Diffusion

论文题目

Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets

1 简介

1)当前视频生成领域普遍都是高质量,但是数据量很小,不符合大数据策略,没有有效的策略做大数据治理,本文针对这个问题提出了视频数据的治理方法

2)作者提出了一个三步走的策略生成视频,一是文生图模型,这一步已经完成,二是视频预训练,强大的视频base model,对视频和文本有很好的表征,三是高质量视频微调,针对不同下游任务做微调

2 方法

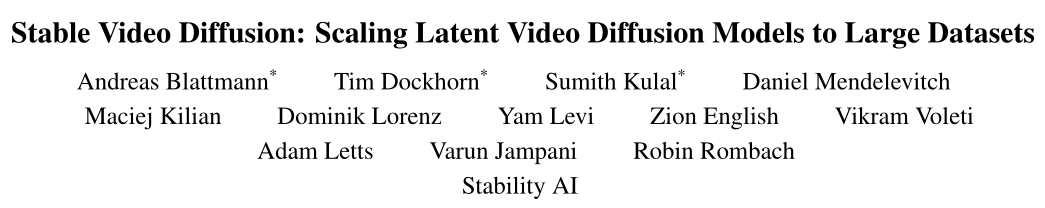

1)数据集LVD,论文题目就强调了Large Datasets,还是大力出奇迹,作者收集了一个LVD视频片段数据集,包含577M 个

2)数据预处理,收集原始视频,然后对原视频做cut detection,也就是镜头切换检测,生成的视频需要镜头连续,不能切换镜头

3)对处理后的数据使用3中方法进行标注,包括图像打标签方式,V -BLIP视频标注方法和第三种方法基于大语言模型 LLM-based标注,得到了每个视频的三种标注

4)经过上面处理后得到577M 视频片段

5)经过试验后发现这个数据集不是最佳的,需要进行一些清洗,让数据质量更高,生成的视频质量才会更高,进行清洗后得到更小的数据集LVD-F,只有152M数据,具体的过滤措施是使用4个角度计算视频和文本对之间的评分,分别是 CLIP scores, aesthetic scores, OCR detection rates, soptical flow scores,

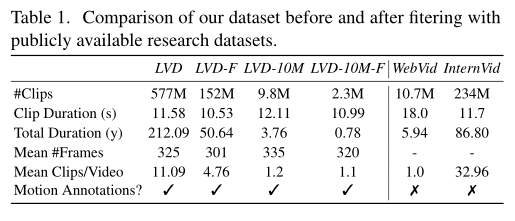

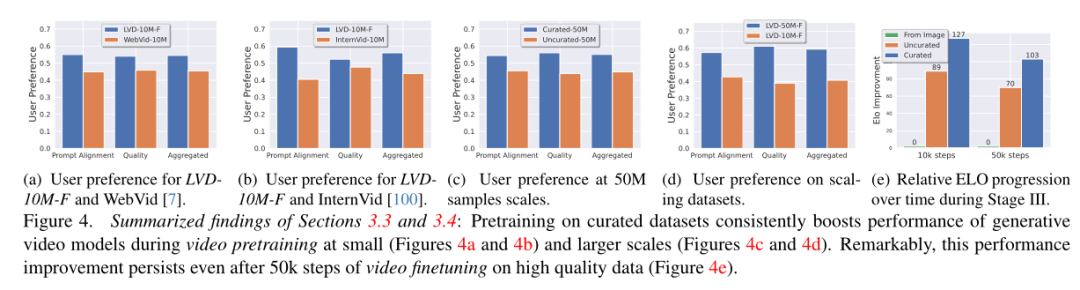

6)有了CLIP scores, aesthetic scores, OCR detection rates, soptical flow scores后,需要设定阈值进行筛选,具体做法是先做随机采样,从577M 随机采样10M数据,然后在这个小一点的数据上做实验,可以让实验更快,然后分成四部分,阈值分别为0.125,0.25,0.5和1,然后在这四个不同大小的子集数据去微调模型,生成视频,让人给这四个视频打分,然后根据得分确定阈值,比如aesthetic scores的阈值为0.25,每个指标都会丢掉一部分数据,最后取交集,得到帅选后的数据集LVD-F

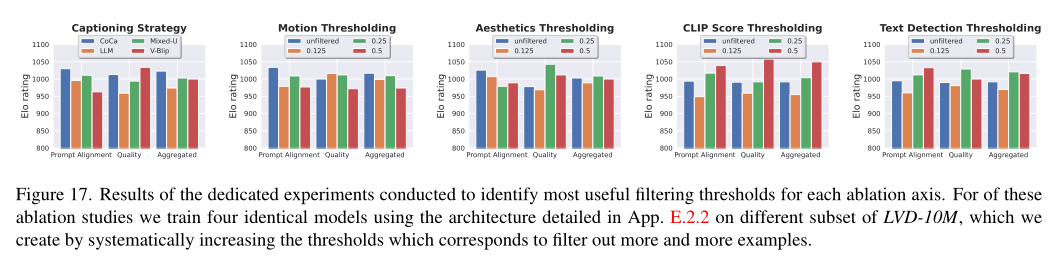

7)作者实验了使用文生图模型初始化的必要性,还是直接随机初始化再视频训练,效果差异还是很大得

8)实验表明数据治理策略是有效的

9)经历过视频数据治理后的模型显著好于直接使用文生图初始化的模型,如图4-e

3 大规模训练视频模型

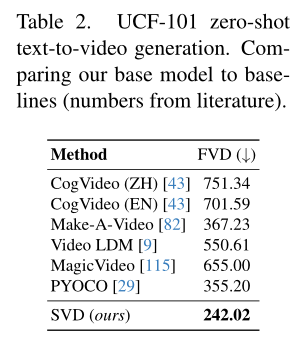

1)预训练基础模型 视频模型基于稳定扩散2.1(SD 2.1)。作为第一步,使用Karras等人[51]提出的针对大小为256 × 384的图像的网络预处理,将图像模型中的固定离散噪声调度调整为连续噪声[87]。在插入时间层后,在分辨率为256 × 384的14帧LVD-F上训练模型。使用标准的EDM噪声计划[51]进行150k次迭代,批量大小为1536。接下来,对模型进行微调,使用批处理大小为768,为100k次迭代生成14 320 × 576帧。我们将此模型称为我们的基本模型,可以很容易地对各种任务进行微调,如下面的部分所示。基本模型已经学习了强大的运动表示,例如,在UCF-101上,它在零镜头文本到视频生成方面的表现明显优于所有基线[88](表2)。

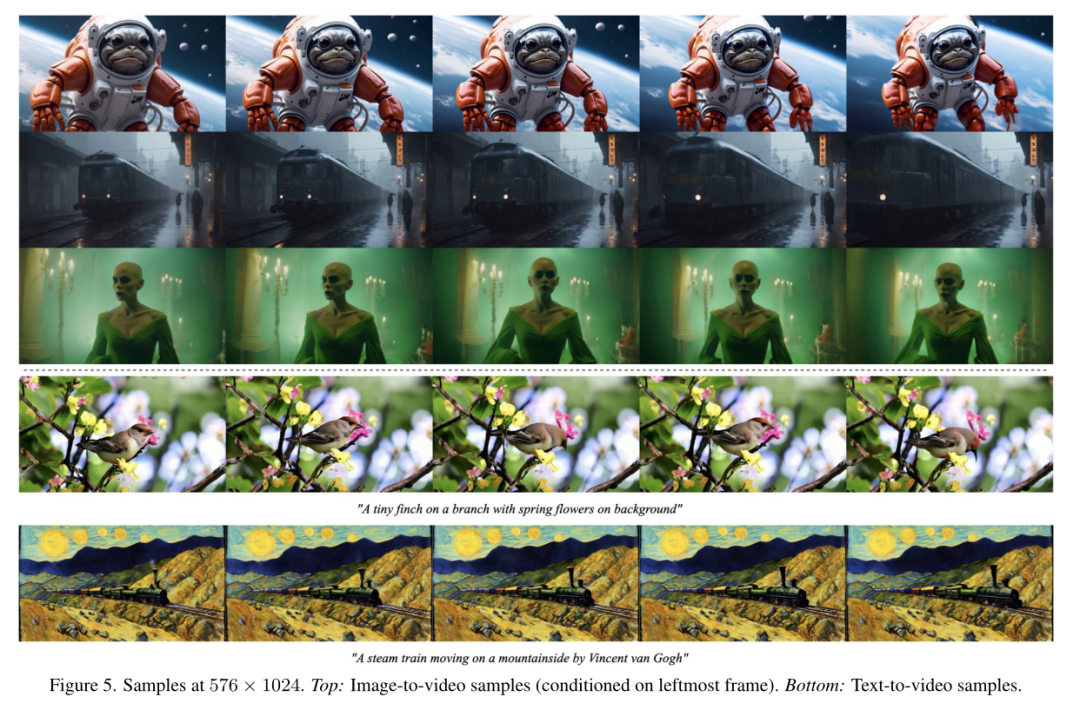

2) 高分辨率文本到视频模型 在约1M样本的高质量视频数据集上对基本文本到视频模型进行了微调。数据集中的样本通常包含大量的物体运动,稳定的相机运动和对齐良好的标题,并且总体上具有高视觉质量。以576 × 1024的分辨率对基础模型进行了50k次迭代的微调(再次将噪声调度改为更大的噪声),使用批量大小为768。如图5示例,

3)高分辨率图像到视频模型 除了文本到视频,还调整了图像到视频生成的基本模型,其中视频模型接收静止输入图像作为条件,将输入到基础模型中的文本嵌入替换为条件反射的CLIP图像嵌入。此外,将一个噪声增强[39]版本的调节帧按信道连接到UNet的输入[73]。没有使用任何掩码技术,只是简单地在时间轴上复制帧。调整了两个模型,一个预测14帧,另一个预测25帧;实现和训练细节可以在App. d中找到。

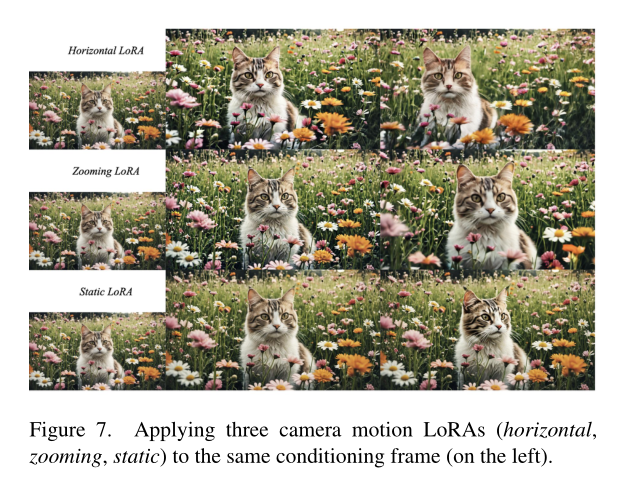

4)Camera Motion LoRA 视频模型一般会加入时序注意力机制,引入LOAR微调方式,只微调时序注意力机制的BLOCK模块,只需要微调很少的参数

5)Frame Interpolation 为了获得高帧率下的平滑视频,将高分辨率文本到视频模型调整为帧插值模型,通过屏蔽将左右帧连接到UNet的输入。该模型在两个条件帧内学习预测三帧,有效地将帧率提高了四帧,非常少量的迭代(≈10k)就足以得到一个好的模型。

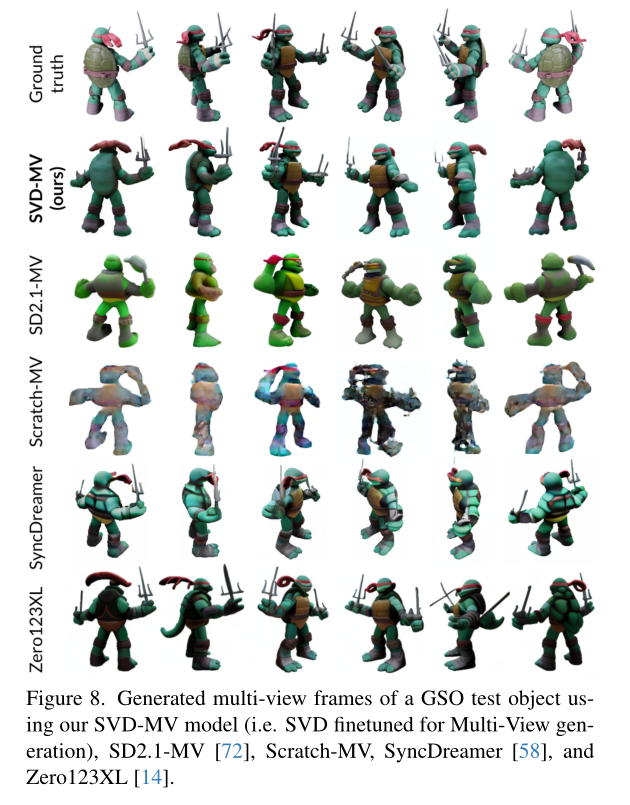

6) Multi-View Generation,输入一个视图,输出其他视图,效果也很不错

将微调多视图模型称为SVD-MV,对SVD的视频先验在多视图生成中的重要性进行了初步研究。为此,比较了来自SVDMV的结果,即来自视频的结果,即来自图像先验的结果,即文本到图像模型SD2.1 (SD2.1 mv),以及没有先验训练的结果,即来自随机初始化(Scratch-MV)。此外,还比较了目前最先进的多视图生成模型Zero123[57]、Zero123XL[14]和syncdream[58]。